Într-un document emis recent de Departamentul Apărării din SUA sunt definite sistemele de arme autonome, respectiv sistemele de arme semi-autonome.

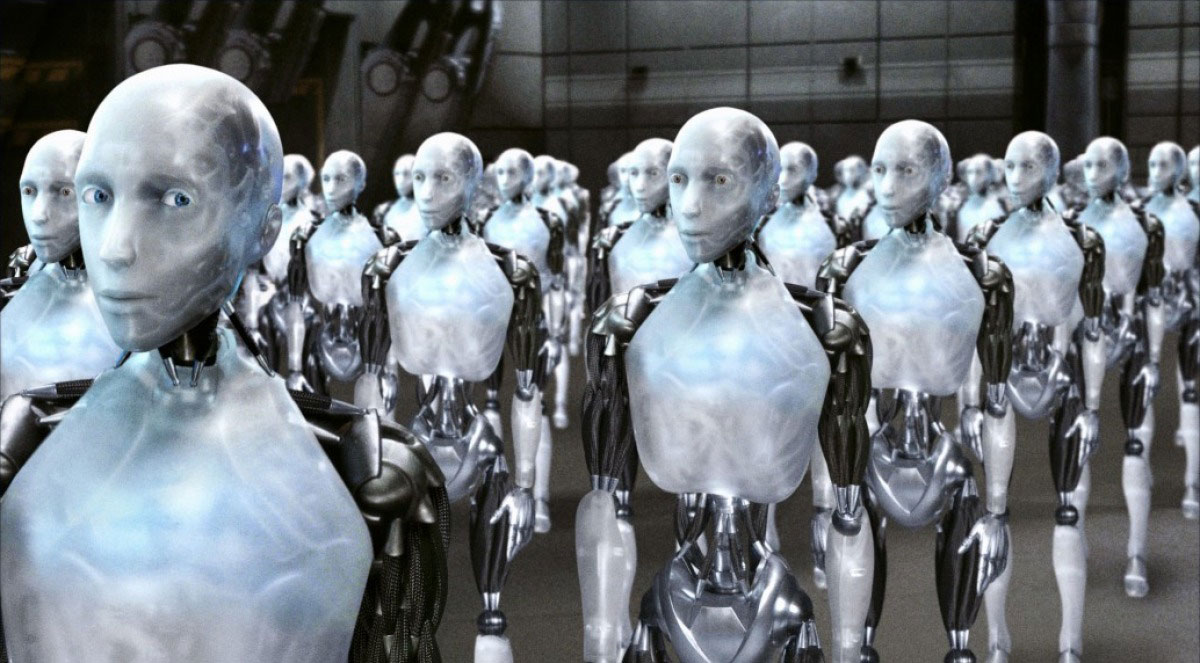

Astfel, un sistem autonom este cel care, o dată activat, poate selecta și angaja în luptă/distruge ținte fără intervenția unui operator uman. Aici sunt incluse și sistemele autonome supravegheate de un operator uman care are posibilitatea de a anula deciziile sistemului autonom.

Un sistem semi-autonom este definit ca fiind sistemul care poate angaja doar țintele alese de un operator uman. Iar aici sunt incluse sistemele capabile de operațiuni automate de urmărire și identificare a potențialelor ținte, inclusiv de evidențiere către operatorul uman și de prioritizare a ordinii în care pot fi angajate eficient țintele identificate. Multe astfel de sisteme, așa cum sunt cele „fire and forget” – trage și uită sau cele „lock-on-after-launch” – alegerea țintei după lansare, sunt deja operaționale.

Am avut ocazia de a vedea la lucru un sistem de comandă și control al unui sistem antiaerian occidental și, în opinia mea, un astfel de sistem poate funcționa deja în mod semi-autonom, reducând foarte mult gradul de solicitare al operatorului uman. Practic, multe operațiuni se desfășoară automat ceea ce permite atât reducerea numărului de operatori umani ai unui astfel de sistem cât și fenomenul de blocare a operatorului în fața supraîncărcării cu prea multe informații.

Din câte știu eu, până acum, nicio armată nu a introdus în serviciul activ sisteme de luptă autonome. Majoritatea sistemelor de luptă fără pilot/echipaj aflate în uz sunt pilotate de la distanță, doar unele operațiuni fiind desfășurate în mod autonom – așa cum sunt de exemplu aterizarea și decolarea sistemelor aeriene fără pilot. Decizia de a ucide aparține întotdeauna operatorului uman. De aici provin și vulnerabilitățile acestor sisteme fără pilot/echipaj care trebuie să comunice în permanență cu stația de control de la sol. Simplu spus, aceste comunicații pot fi interceptate sau bruiate ceea ce poate conduce la pierderea sistemului respectiv. Un exemplu celebru este pierderea de către SUA a unui sistem aerian fără pilot RQ-170 Sentinel în Iran, în decembrie 2011.

O altă problemă specifică sistemelor autonome/automatizate este faptul că se bazează pe informațiile furnizate de senzori multipli care se pot defecta sau funcționa necorespunzător. Problemele complexe generate de computerele care controlează informațiile furnizate de senzori și legile multiple pe care le aplică au fost deja evidențiate cu ocazia mai multor incidente/accidente aviatice de notorietate. Unele dintre primele incidente de acest tip au fost generate de Airbus A-330, un avion revoluționar la vremea lui – zborul Qantas 72 sau zborul Air France 447. Mie mi-au rămas întipărite în minte cuvintele unui pilot dintr-un episod „Dezastre în aer”: „What’s the plane doing?” Această scurtă propoziție evidențiază nenumăratele provocări generate de operarea unor sisteme automatizate/semi-autonome fără o înțelegere profundă și adecvată a modului lor de funcționare. De dezastrul Boeing 737 MAX nici nu mai amintesc…

Revenind la sistemele militare, Departamentul apărării american dorește să implementeze politici transparente cu privire la utilizarea armelor autonome bazate pe acest cuvânt atât de uzitat în ultima vreme – inteligența artificială. Adică, roboți care pot ucide oameni. Despre asta este vorba în Directiva 3000.09 – Autonomy in Weapon Systems, recent emisă. Mai jos declarația doamnei Kathleen Hicks, deputy secretary of defense, pe acest subiect:

DoD is committed to developing and employing all weapon systems, including those with autonomous features and functions, in a responsible and lawful manner. Given the dramatic advances in technology happening all around us, the update to our Autonomy in Weapon Systems directive will help ensure we remain the global leader of not only developing and deploying new systems, but also safety.

Pe scurt, Pentagonul încearcă să prevină un scenariu de genul Terminator încercând să diminueze probabilitatea și consecințele unor posibile erori ale roboților ucigași autonomi/semi-autonomi de natură a conduce la tragedii nedorite. De altfel, tragedii s-au și întâmplat în condițiile utilizării extensive a sistemelor aeriene fără echipaj (pilotate de la distanță) în detrimentul forțelor speciale, mai ales în cadrul campaniei împotriva terorismului. Câteva informații suplimentare aici.

Mai departe, Directiva statuează că “Autonomous and semi-autonomous weapon systems will be designed to allow commanders and operators to exercise appropriate levels of human judgment over the use of force (…) with appropriate care and in accordance with the law of war, applicable treaties, weapon system safety rules, and applicable rules of engagement.” Mda…

Deși Directiva nu interzice incorporarea inteligenței artificiale în sistemele de luptă autonome/semi-autonome impune totuși respectarea principiilor etice de utilizare a inteligenței artificiale. Îhî…

Subiectul este dezbătut și în cadrul Națiunilor Unite, de fapt cam toată lumea dezbate fără a se întâmpla nimic concret în sensul adoptării unei legislații internaționale în materie.

Isaac Asimov a scris cele trei legi ale roboticii în 1942 (seria Roboții). Prima Lege – „Un robot nu poate răni o ființă umană sau, prin inacțiune, să permită ca o ființă umană să fie rănită”, a Doua Lege – „Un robot trebuie să se supună ordinelor date de ființele umane, cu excepția cazului în care aceste ordine ar intra în conflict cu prima lege” și a Treia Lege: „Un robot trebuie să își protejeze propria existență, atâta timp cât această protecție nu intră în conflict cu Prima sau a Doua Lege”. Cine este familiar cu universul roboților lui Asimov știu că a fost formulată și Legea Zero: „Un robot nu are voie să pricinuiască vreun rău umanității sau să permită prin neintervenție ca umanitatea să fie pusă în pericol.” De menționat că Legea Zero prevalează și a fost formulată de… un robot.

Bineînțeles, legile de mai sus sunt pură ficțiune. Pe de altă parte, pe măsură ce tehnologia roboților ucigași avansează, aceste legi încep să capete din ce în ce mai multă relevanță în viața reală. De pildă, NICE, o companie de tehnologie, automatizări etc, a formulat următoarele legi (preluate în română de aici):

Prima Lege: Roboții trebuie să fie proiectați doar pentru a avea un impact pozitiv. Luând în considerare impactul social, economic și de mediu, fiecare proiect care va implica roboți ar trebui să aibă cel puțin un scop pozitiv clar definit. Pare evident? Nu e. De exemplu, Rusia și China au alte planuri – și dacă pentru Moscova invadarea vecinilor cu roboți ucigași o fi scop pozitiv, pentru noi prin Europa de Est cert nu-i.

A Doua Lege: Roboții trebuie să fie proiectați să nu țină cont de identitățile de grup. Poate pare cam prea SJW, dar nu-i. O companie americană ce folosea IA pentru a selecta CV-uri a descoperit că nu mai angaja pe nimeni de culoare. De ce? IA-ul văzuse statistic faptul că doritorii din unele cartiere avuseseră în trecut rata foarte mică de calificare, așa că-i elimina din start. O concluzie matematică perfect rațională, bazată pe statistici. Din anii 50-60, când funcționa segregarea – dar robotul nu știe să interpreteze și contextul datelor. Ce zic ele matematic, aia crede. Dar dacă vii azi din acel cartier și totuși ai făcut o școală, poate în cartierul vecin? Și ești calificat, dar practic nu mai exiști? Sună puțin PKD, nu?

A Treia Lege: Roboții trebuie să fie proiectați pentru a reduce la minim riscul de vătămare individuală. Adică algoritmii, procesele și deciziile încorporate în roboți ar trebui să fie transparente, iar oamenii să le poată audita și controla. Dacă un robot pune în pericol un om într-o situație individuală, alt om ar trebui să poată verifica și corecta procesele, pentru a preveni incidentele viitoare. Aici, zic eu, e cam Prima Lege de Asimov, doar că ceva mai flexibilă (spre binele robotului, care nu ar mai risca direct dezasamblarea, ci doar reprogramarea rutinei vinovate).

A Patra Lege: Roboții trebuie să funcționeze doar pe date din surse verificate. Roboții ar trebui să funcționeze numai pe baza unor date din surse cunoscute, de încredere și declarate transparent, cu garantarea posibilității de a ajunge la sursa originală. Aici probabil chinezii vor plânge puțin, dar vor fi evitate și multe scenarii cyberpunk…

A Cincea Lege: Roboții trebuie să fie proiectați pentru a fi controlabili și administrabili. În traducere, administrabili adică utilizatorul uman să fie informat corect despre toate aptitudinile și limitările sistemului – și aici rămânem fără multe scenarii SF, când robotul poate mai multe decât știe stăpânul… Iar controlabili în sensul că accesul la ei trebuie să fie doar cu autentificare și să aibă sisteme de apărare, care să monitorizeze și să alerteze când se încearcă editarea softului. O idee de bun-simț, de altfel, dar deloc obligatorie azi.

Ca de obicei, legislația nu poate ține pasul cu evoluția rapidă a tehnologiei, ceea ce nu face decât să creeze zone gri care, mai apoi, sunt exploatate de actorii statali sau non-statali mai mult sau mai puțin bine intenționați. 5G va aduce noi și noi oportunități pentru extinderea utilizării sistemelor autonome/semi-autonome, atât în mediul civil, cât și în mediul militar. Nicio lege actuală nu ne spune ce se întâmplă în cazul în care o mașină autonomă produce un accident soldat cu victime umane. Similar, sistemele militare autonome/semi-autonome sau chiar pilotate de la distanță nu se regăsesc în legislația internațională ceea ce va ridica o multitudine de probleme, așa cum au fost situațiile în care aceste sisteme au fost capturate de actori statali/non-statali în baza unor argumente destul de subțiri…

China are o durere la 2m in fata de problemele etice,sunt in top mondial in materie de AI.Nu fac clasamente,ca e activitate de adolescenti si nici nu conteaza ca sunt pe locul 2,3 sau 7.

Relevant e ca nu poti controla ce fac,neexistand un mecanism batut in cuie,cum e cazul armelor nucleare in relatia SUA-Rusia.Asa incat paranoia e cel mai sigur comportament.Daca se poate ceva rau,sa presupunem ca o fac.

Mai e de tinut cont ca ce-i intereseaza pe ei,adica aerul,marea,viteza de decizie ,spectrul electromagnetic sunt toate mai lesne pretabile la automatizare decat lupta terestra si ca 80% e mai bun decat 100%.

Asa incat nu cred ca e posibila respectarea principiilor morale cu care se framanta multa lume de vreo 2 decenii.Sau cel putin,pt fiecare aspect care va ajunge la trupe public sa existe si versiunea ”dark side of the force”.In caz de nevoie,faci un update si te apuci sa tragi o tigara(ca nu stii daca e ultima).

„Daca se poate ceva rau,sa presupunem ca o fac” – exista suspiciuni despre China si in domeniul clonarii umane, tinanad cont ca au clonat deja primate.

Pentru o clona sa fie viabila se cloneaza copilul de la nastere, si da sunt clone foarte multe extrem de multe, membrii structurilor de forta si control este plin de eii acolo.

@Cristi

E un pic cam off topic, singura legatura cu articolul de mai sus e ca vorbim despre etica in general, ar trebui sa vorbim mai exact despre etica in inteligenta artificiala si nu despre etica in clonare.

Primul animal clonat (in mod oficial) a fost Dolly si nu a fost in China

https://dolly.roslin.ed.ac.uk/facts/the-life-of-dolly/index.html

In cea ce priveste experimentele genetice umane din China de pana in prezent in mod oficial nu stim mare lucru. Nu ne putem baza doar pe afirmatii fara nici o proba. Doar suspiciuni.

Medicul chinez, He Jiankui, care a modificat genetic copii a fost condamnat le 3 ani de inchisoare in 2019 si nu a mai fost vazut de atunci. Acum ar trebui sa fie in libertate.

”A court in Shenzhen found that He and two collaborators forged ethical review documents and misled doctors into unknowingly implanting gene-edited embryos into two women, according to Xinhua, China’s state-run press agency. One mother gave birth to twin girls in November 2018; it has not been made clear when the third baby was born.”

https://www.science.org/content/article/chinese-scientist-who-produced-genetically-altered-babies-sentenced-3-years-jail

Mai mult de atat eu nu stiu. Identitatea copiilor este tinuta secreta sa nu aiba de suferit din cauza asta si bine fac. Nu sunt copii de vina ca adultii sunt niste idioti.

Restul sunt speculatii sau deductii logice dupa parerea mea dar tot fara probe.

Daca tot vorbim de genetica si etica in genetica, in Rusia acum cateva zile persedintele Putin a aprobat legea ADN -ului, mai exact a colectarii lui.

https://tass.ru/obschestvo/16969429

Scuze pentru link-ul in limba rusa, apasati pe butonul traducere in engleza.

Exista articole si in media romaneasca referitor la subiect dar ca de obicei nu vreau sa fac reclama gratuita la nimeni.

Este etic?

Este moral?

Dar ca sa revin la subiectul de baza etica in inteligenta artificaial si ca tot ati pomenit de China, cel mai mare efort facut de partidul comunist chinez este in dezvoltarea inteligentei artificale pentru controlul si supravegherea populatiei.

Drumul spre iad e pavat cu cele mai bune intentii..

Este etic?

Este moral?

Este o arma in mana guvernelor, supravegherea fiecarui individ cu ajutorul IA, 24/24, 7/7, de la nastere pana la moarte, chiar daca teoretic cu bune intentii declarate in mod oficial.

Nu explodeaza, nu face zgomot, nu o vezi, nu o simti, dar iti poate face rau, IA te vede, te simte si te urmareste peste tot, in casa, pe strada, la munca, la crasma, la curve etc.

Iata un documentar foarte bun facut pe tema asta de DW.

Cine are de inteles, intelege mai mult, pana la ce nivel s-a ajuns asupra controlului populatiei cu ajutorul IA.

Asta e numai varful icebergului.

Vizionare placuta.

https://www.youtube.com/watch?v=7gSU_Xes3GQ

Cea mai utila si eficienta usor de inlocuit este clona umana sunt absolut singur ca sistemul lucreaza si perfectionat asta.

Morala tine de cultura…

Cultura chineza este diferita de a noastra … A :niastra” este influentata de crestinism

@Ghita

” este influentata de crestinism”

Si a rusilor, si a nemtilor, si a italienilor, si a americanilor, si a noastra ca români.

Sincer nu am inteles afirmatia.

Suntem noi mai morali decat asiaticii sau necrestinii?

Uitate in jurul tau ce fac asa zisii crestini si ce au facut si in trecut.

Nu as zice ca avem superioritate morala si oricum superioritatea morala e un concept foarte periculos (deosebit de periculos). Unul din argumentele folosite in declansarea si justificarea razboaielor e superioritate morala. Suntem noi mai etici sau mai morali decat altii? Iar de superioritate culturala nici nu are sens sa mai vorbim.

Eu zic ca suntem la fel de nemernici ca toti ceilalti.

Morala si etica tine de un individ si nu de un grup.

E suficient ca in fruntea grupului sa ajunga un individ fara etica si morala si s-a dus dracului toata sandramaua, chiar daca in randul membrilor grupului exista oameni cu pricipii si morala. Dar se poate cimenta si impune prin legi, asa cum e mentonat mai sus in articol.

Culura noastra, adica a popualtiilor de tipo european

Vrea sa spuna faptul ca anumite atitudini care pot parea acceptabile aici in culturile asiatice apar ca imorale si invers.

China nu va reusi prea curand sa creeze sisteme autonome in domeniu militar. Poate ca au soft, hardware, datalink dar niciodata nu vor reusi algoritmi predictivi fara date istorice. Nu au nicio sansa in fata americanilor care folosesc systeme semiautonome de 20 de ani si au in spate ferme de servere cu date. Pana si turcii sunt mai avansati la drone aeriene. Ma intrebam si eu de ce au facut acele declaratii, parerea mea e ca forteaza alocari bugetare pentru a pune in picioare proiecte.

China mai are o mare problema pe care eu am mai spus-o pe aici. Acolo oamenii sunt invatati sa respecte anumite tipare. Si atunci cand toata viata ta e un tipar este ceva mai greu sa gandesti outside the box.

Chiar si acum unul dintre clientii nostri are o filiala in China. Seriosi oamenii si muncitori dar daca s-a schimbat o virgula in documentatie sunt blocati. Si totusi sunt oameni buni pe bucatica lor, care au experienta nu juniori iesiti de pe bancile scolii.

Acum eu sunt ferm convins ca, din alea 2 miliarde cati or fi ei, au si oameni capabili sa gandeasca outside de box. Doar ca sunt putini si nu poti sa-i iei pe aia toti sa lucreze la proiecte militare. Bine, la ei se poate, dar sigur n-au un inventar al lor.

Iar chestia asta cu inteligenta artificiala, desi suna frumos ca nu mai ai nevoie de omuleti, tot iti mai trebuie cate unul sa-ti bagi server-ul in priza si alte alea.

deci matematic nu au dispersie, chiar daca mai gasesti cativa outside, statistic extremele se ignora ?.

probabil de aia trag tare sa ia profile din occident.

Apropos ca veni vorba, indienii sunt fix la fel. Daca scoti o virgula sau daca nu primesc nivelul de cel mic detaliu sunt blocati.

Turci nu sunt avansati in clone majoritatea componentelor sunt de import ambaleaza si vand frumos a doua oara.

Imi aminteam vag ceva, acum am avut timp sa caut nitel. Pana la China, s-ar putea ca Turcia sa fi folosit deja in Libia o drona in mod complet autonom (fara supervizarea omului) pentru a ucide:

https://www.popularmechanics.com/military/weapons/a36559508/drones-autonomously-attacked-humans-libya-united-nations-report/

Raportul este neconfirmat pentru ca toata tarasenia tine de software si pe ala n-au reusit sa-l „scoata” din resturile carbonizate ale dronei.

Cel mai probabil, multumita avansului tehnologiilor de recunoastere a tintei (cum are si NSM, de exemplu), toate munitiile kamikaze au si un mod autonom „scris” in software-ul lor.

„Pana la China, s-ar putea ca Turcia sa fi folosit deja in Libia o drona in mod complet autonom”

Misiunile zburate de RQ-170 sau RQ-180 in spatiu contestat zboara in felul acesta de an de zile. De aici si foarte proasta analogia cu doborarea unui RQ-170 de catre iranieni. Simplu caz de multi vad putin cunosc. Nu zbori in spatiu contestat direct zburand conservele astea prin a emana tot felul de semnale in spectrul electromagentic.

N-am pretentia ca-s cea mai iscusita penita din toc… 🙂

Exemplul a fost pur si simplu foarte la indemna, prin senzationalul sau si multumita goagal care l-a pus pe prima pagina.

Nu se stiu prea multe despre RQ-170, din ce am mai citit, iranienii ar fi manipulat semnalul GPS facand drona sa creada ca a ajuns acasa. Sau ceva in genul asta.

Dar e logic ce spui tu. Cat de autonoma e de fapt RQ-170, probabil doar aia de la Skunk Works o stiu.

Nu ai ce sa manipulezi. Conservele astea navighează folosindu-se de INS și nu de GPS.

Uneori e mai bine sa fii suficient de păaranoic decat sa fii prea putin….

Hm… na poftim o arma proasta, da prosta bata, care se doreste a fi interisa – mina antipersonal. Dar macar e fixa!!

E .. si acu cam ce ar putea face o arma autonoma , cu capacitati de miscare si achizitie proprie a tintei ?

A! Nu ! Ca cica o sa fie o intelugenta , fie ea si artificala, care sa conduca arma .

Vi se pare suficient? Da?

Dar oare ala … Mengele nu era inteligent?

Era si … ?

Inteligentas in sine nu este o garanatie. Ca e artificiala si mai putun – dinati ar trebui sa stabilim ce este aia prostia naturala!!

Cand e voorba de IA eu sunt suficient de paranoic . Nu de lata dar ar trebui proiectata de inteligenta umana .. care ea are unele hibe „comportamentale” …. simaitin minte ca un medic „de glumeti” zicea ca pacientii sai sunt extrem de rationali …. prea!!

_____________________________________________

Si cestia cu duficient de parano.. O veche carivcatura (franceza parca) – un personaj imbracat ca un contemporan a lui Machiavelii mediteaza pe tron „Bine, sunt paranoic. Intrebarea ce se pune este daca sunt suficient de paranoic?”

Tot un om da comanda.

Gabita

ai idee ce este aia o mina antipersonal?

@nicolae, frumos subiect, la asta sigur nu se vor baga trolii si hauriferii:

Teoretic si legal ai perfecta dreptate, dar realitatea este mai simpla si pragmatica. In momentul de fata omenirea a intrat in ceea ce se numeste „paradoxul tehnologic”.

O sa incep de la istorie, de fiecare data oamenii au fost speriati de masini, cand ajungea prima oara un tren undeva satenii se speriau de zgomot si suierat, primele vehicule erau urate de carutasi pentru ca speriau caii. De fiecare data necunoscutul aduce reticenta dar de fiecare data ajunge sa castige din teritoriul task-urilor umane, dar cu fiecare avans numarul celor care inteleg ce se intampla cu masina scade.

Noi acum ca si societate am intrat in era paradoxului tehnologic. Este un fenomen grav si invizibil, dar il traim zilnic. In fiecare zi task-urile nostre sunt preluate de masini din ce in ce mai performante care ajung sa faca 95% din munca si pe cat posibil sa solicite userului doar imputuri sau validari. Dar 99% din useri habar nu au ce se intampla in spatele masinii, este un monkey people care apasa pe niste butoane in o succesiune configurata in workflow si completeaza niste campuri mandatary escaladate de aplicatie.

Asa s-a ajuns ca nivelul de cunostere sa se concentreze in mana unui grup extrem de mic de oameni care cunosc e2e procese complexe. O idee gresita este ca programatorul stie ce a facut acolo, asta merge la chestii uzuale simple, dar la chestii complexe (mai ales la procese cu aplicatii integrate) programatorul este un code writer care scrie o bucata mica pe baza unor regului primite doar pentru acea functionalitate. De regula nu cunoste big picture ci doar o mica componenta.

Si uite asa in realitate se ajunge ca in ciuda tuturor regulilor (zise si de tine) ca userul ajunge sa ia decizii pe baza evaluarilor facute de system (de care nu are habar 99%), care are in spate un cod scris din bucati asamblate, iar singurii care stiu ce este acolo si sa interpreteze corect o posibila eroare sunt o mana de oameni care de multe ori sunt cvasinecunoscuti sau inaccesibili. In tehnica exista un principiu, cu cat un system este mai complex cu atata devine mai periculos pentru ca probabilitatea (rate%) defectiunilor se insumeaza. De aceea produsele nascute prin evolutie sunt mai bune decat cele complet noi.

Legat de systeme full autonome complexe, ele deja incep sa apara (Tesla) si in orizontul de 10 ani vor fi din ce in ce mai prezente pana cand validarea userului uman va deveni doar o simpla confirmare.

Legat de AI, aici nu este chiar asa de simplu, multi confunda AI-ul cu ce au pe telefon in picture sau cu aplicatii care scaneaza si OCR-izeaza documente. No way, asta este ceva super basic, AI-ul de care discutam este un algoritm mult mai evoluat care ia decizii si e trigger de processe complexe (gen autopilot Tesla) si care va primi cel mult o validare de „run”.

Dar ca un AI sa se poate dezvolta este necesara cumularea mai multor cerinte: soft (nu e asa de complex), putere de procesare (asteptam procesoare cuantice), capacitate de stoare mare si viteza R/W (hard-uri noi cu stocare la nivel atomic), datalink cu viteza mare (5G, satelitar) / securizare si cel mai important date istorice imense cu request/response pe care sa-si valideze predictiile + timp (asa cum noi invatam in ani si el isi va rafina predictia in miliarde de cicluri).

Legat de legi, pana acum legile au franat evolutia dar in situatii de criza (razboaie) cand a fost facut bypass, omenirea a avansat tehnologic in 5 ani cat in 50, chiar daca prin riscuri si probleme.

Multam ADR si multam si de comentariu, foarte interesant! E un domeniu la care ma pricep putin spre deloc, de aceea am si dorit sa provoc o discutie. Acum, imi dau seama ca am formulat articolul cam alambicat iar titlul poate induce oarecum in eroare.

Citem mai demult (nu mai stiu pe cine, Friedman, Toffler, habar n-am) ca ordinea reactiilor este intotdeauna urmatoarea: tehnologie – politic – legislatie. La ultima ma mai pricep cat de cat, de aceea si fraza de final.

Nu doar legislatia franeaza avansul tehnologic. Exemplul pe care-l dai, dezvoltarea accelerate pe timp de razboi, presupune intotdeaua alocarea unor resurse extraordinare care nu-s nici pe departe bazate pe ratiuni economice.

Si eu cred ca momentan IA-ul este un concept gresit inteles de marea majoritate a publicului larg si, in tot cazul, inca nu suntem acolo. Dar este la moda si gem pliantele publicitare de IA.

Cred ca in acest moment, suntem undeva la granita dintre semi-autonom si autonom ca sa folosesc definitiile americanilor. Dar sistemele autonome sunt aproape si deja genereaza probleme precum cele din articolele de mai jos:

https://www.usni.org/magazines/proceedings/2023/january/protect-unmanned-surface-vessels-gray-zone

https://www.usni.org/magazines/proceedings/2023/january/autonomous-merchant-ships-are-coming-are-we-ready

Adaug urmatoarea problema teoretica usor naiva dar la indemana:

Un sistem autonom pleaca la vanatoare intr-o misiune de lupta impotriva unor tinte de la sol cu niste obiective clare. Sa presupunem ca se bazeaza pe un sistem IFF care-l ajuta sa distinga trupele proprii de cele ale inamicului. Sa presupunem si ca are alternativa de a recunoastre trupele proprii dupa uniforme, doar ca aia-s toti plini de noroi de nu se mai disting bine intre ei. Si se pune pe omorat pana ramane fara munitie. Printre rafale, mai doboara si niste civili rataciti pe-acolo prin zona. Now what? Avem o eroare generata de nefunctionarea unui subsistem, senzor etc de-asta am si dat exemplele cu avioanele. Stiu ca poti adauga sisteme redundante etc samd dar sa presupunem de dragul exemplului ca nu functioneaza.

„Legat de AI, aici nu este chiar asa de simplu, multi confunda AI-ul cu ce au pe telefon in picture sau cu aplicatii care scaneaza si OCR-izeaza documente. No way, asta este ceva super basic, AI-ul de care discutam este un algoritm mult mai evoluat care ia decizii si e trigger de processe complexe (gen autopilot Tesla) si care va primi cel mult o validare de „run”.”

DISA se foloseste de ani buni de AI pentru a apara retelele de comunicatii ale DoD. DISN/DoDIN NOC si Theater NetOps Center de la Stuttgart functioneaza practic fara personal.

„DISN/DoDIN NOC si Theater NetOps Center de la Stuttgart functioneaza practic fara personal.”

Nu va mai fi job pe pamant ce nu poate AI sa il faca. Cred ca in 100 de ani suntem scosi la pensie sau cine stie poate mai devreme si apuc sa traiesc schimbarile astea.

@Robi

Glumesti, 100 de ani.

Mult mai putin.

https://interestingengineering.com/innovation/ai-powered-f-16-jets

Viteza cu care AI se dezvolta nu are precedent.

Ai apucat deja fara macar sa poti sa iti dai seama.

https://www.cnet.com/tech/computing/ai-is-speeding-us-toward-intelligent-computers-and-the-singularity-pioneer-says/

Hai sa fim seriosi, etica a fost intotdeauna o chestie optionala si buna mai mult pt discutii in saloanele de bal. In razboiul real, ramai tu si propria ta constiinta.

@George GMT

Ca de obicei tot americanii saracii duc greul si au initiative.

De ce ?

Simplu, ei stiu foarte bine cat de departe au ajuns in domeiul IA.

Ca ceilalti nu o sa subscrie e o alta treaba, macar sa nu spuna ca nu s-a dorit si ca nu s-a incercat.

https://abcnews.go.com/Business/wireStory/us-launches-artificial-intelligence-military-initiative-97256626

@Nicolae. Introdu și tu o erată – mda, Zeroth Law a fost formulată de un robot, dar doar personaj în *Robots and Empire* tot a lui Asimov, deci … deși n-a fost scrisă de un om ci de Asimov, n-a fost scrisă nici de un robot … O tempora … Mai am *Robots and Empire* – am primit-o cadou în iarna ’88 de la un unchi care a comandat-o cu 6 luni înainte prin rude de *afară* și adusă prin contrabandă pe Clisură prin intermediul altor rude și o țin și acum în bibliotecă … No’fence please!

Dilema ta morală seamănă cu dilemele morale dezbătute pe la cursurile de bioetică – toată doctorimea se dă de ceasu’ morții să-ntoarcă pe toate părțile paiu’ cu dilema morală a eutanasiei da’ nici-unu’ nu crâcnește nimic când se-nvârte în fiecare zi pe lângă bârna cu moralitatea / legitimitatea / legalitatea comisioanelor de la terți subsecvente actului medical. Adică paiu’ tău cu ce va putea / ce nu va putea face un cutting-edge hash-hash robot din viitorul mai mult sau mai puțin SF e nimic pe lângă bârna unor coduri etice și profesionale în programare, inclusiv în domeniul militar. … Once again – no offence, please !

După mine, a trecut deja juma’ de secol de programare, adică suficient timp de a putea considera domeniul IT ceva suficient consolidat pentru a i se putea aplica reguli etice, dar evoluția e contrară normalității morale.

Exemplu de evoluție : UNIX free, Linux free dar cu structură fixă, Android 1 free cu ghilimele, Android 10 free cu ghilimele plus cu acces blocat la Google Services – moral ar fi fost evoluția către sisteme cât mai libere … Da’ libertate nici oamenii nu mai vor – Apple cu sisteme integral dependente de producător a crescut ca pondere în piață … Weird life …

Similar, în domeniul militar – până să ni se facă frică de Terminator și Skynet, în absența unor norme măcar etice de acces și control al proprietarului unui asset la *black-box*-ul acestuia reprezentat de sistemul informatic. De adus aminte poveștile de la Revoluție cu pomu’ cu luminițe de crăciun de pe radarele militare de fabricație sovietică asupra cărora armia română avea control limitat – moral ? Nu știu, da’ știu că ne-am autofaultat bine atunci …

Alt exemplu : din punct de vedere moral, este corect ca principiu să te milogești de elvețieni dacă vrei să faci rodaju’ la Piranha 5 prin Ucraina că doar e mașina ta, cumpărată cinstit la suprapreț cu toate taxele incluse? E corect ca principiu să te milogești de evrei dacă vrei să refolosești creativ proprietatea ta, racheta Magic ce stătea pe Lancer, cumpărată acu’ 25 de ani de la Elbit ? E corect ca principiu să devii client captiv pentru aproape orice tehnologie militară ?

Dădeai exemplul cu MAX-i fâsu’ Boeing – acolo nu era o problemă de funcționare anti-umană a inteligenței artificiale ci o problemă de programare proastă pe motiv de management prost.

Așa că … paiu’ sau bârna ?

Asimov a scris toate „legile”. Eu ma refeream la ce se intampla in carte: primele trei legi sunt formulate de oameni, a patra de R. Daneel Olivaw, un robot. Am crezut ca e destul de clar acest lucru.

Exemplele cu catastrofele aviatice au fost date pentru a evidentia esecul unui sistem semi-autonom as spune eu (i.e. pilotul automat) in fata defectiunii senzorilor care au inceput sa furnizeze informatii eronate. Este ceea ce se poate intampla si cu un sistem autonom/semi-autonom militar.

Recunosc, titlul induce in eroare, poate n-a fost cea mai buna alegere. Dar articolul nu se reduce la dileme morale, am urmarit o sfera de cuprindere mai larga. Aparent, judecand comentariul tau, n-am prea reusit.

Friendly fire si erori se intampla si in cazul sistemelor controlate integral de oameni. Dar, de exemplu, acea situatie este acoperita legal. Sau ala se prinde ca a gresit si se opreste limitand daunele. La fel si in cazul tragediilor provocate de sistemele aeriene (cele mai raspandite) pilotate de la distanta. Uneori, boots on the ground e mai safe.

P.S. Apropos, s-a insistat foarte mult ca sistemul C4I sa fie dezvoltat in tara.

P.P.S. Dilema morala apartine Departamentului Apararii al SUA care a emis Directiva 3000.09…

@nicolae. Ooooffff … mă zgândărași la nostalgii cu Daneel … câteodată mai visez cum ar fi să trăiesc ca el toată epoca Primului Imperiu … deși nu-mi plăcea să fiu ca el că doar mima empatia … niște roboți, dom’le, niște roboți … Și eu în schimb te frec pe mărunțișuri … pune-le la friendly fire … cam ca ucraineanu’ ăla de făcea cu mâna la drona alor lui și s-a ales cu grenada dronei în cap … tot dileme morale …

Încep cu post-scriptum-urile tale – și eu am apreciat pozitiv insistența armatei în sistemele informatice făcute cu mânuța semi-proprie, chiar în ciuda rateurilor cu integrarea turelei pe Piranha și chiar în ciuda dubiilor când îmi mirosea a fantomă de Sebastian Ghiță. Nu știu despre directiva US DoD decât titlul – oricum ce face Uncle Sam e science-fiction pentru noi. Și să știi că ai reușit să abordezi esența conceptului general de moralitate în A.I. cu exemplificarea din domeniul aero.

Problema pusă de mine era de oportunitate în focalizarea pe probleme – până să dezbatem concepte de no-man-in-the-loop, care da, sunt fascinante, sunt hush-hush, dar mai aproape de noi ar fi problemele din sfera IT legate de blocajele și limitările impuse de acceptarea de rumânașii noștri cu pupile în formă de $$$ a unor sisteme informatice blocate fie de interesele financiare ale furnizorului de echipamente ce a câștigat anterior poziție dominantă, fie de interesele politice ale guvernului din spatele respectivei afaceri.

În problematica pusă de mine ar cam trebui eliminată discuția despre interesele financiare directe ale actorilor, pentru că dezbaterea s-ar degrada până la concluzia inevitabilă *ce țară de c…t condusă de c…cănari avem*. Oricum, aceasta e o problemă care ar reveni în orice punct al discuției și încă pe bună dreptate – spre exemplu, cum să poți analiza ce algoritmi trebuie să utilizeze software-ul când vezi că MApN lansează o licitație pentru 4 bucăți de fer cu 16 artifcii AA și 8 AN, fără să-l pese tipul de rachete, tactica la care se pretează, performanțele rachetelor și senzorilor, etc. ?

Eu abordam ideea enunțării unor principii morale de funcționare ale sistemelor IT care să dicteze modul de achiziție / construcție / optimizare al acestora. Spre exemplu, eu, când vreau să cumpăr sau să construiesc un software, sau chiar doar să învăț să lucrez pe el, mă uit să nu mă coste așa mult mentenanța și operarea, mă uit să am măcar speranța unei utilizări mai lungi (și nu să devină inutilizabil la primul update de sistem de operare), mă uit să găsesc niște prieteni fără ghilimele care să-l mai utilizeze și cu care să mă pot consulta, mă uit să pot dezvolta sistemul sau să-l operez și după ce dispare sprijinul tehnic al producătorului, etc.

Pentru marea majoritate a oamenilor domeniul IT este un big black hole, care da, duce la atitudini mistice în abordarea lor, inclusiv la pecepții de gen *laser, frate … da’ nu orice laser, ci fix laseru’ lu’ Coandă*. Și din păcate segmentul *laser frate …* e din ce în ce mai mare, în primul rând din cauza reducerii dramatice a apetenței educaționale pentru științe exacte. Exemplu – de curând, un patron de atelier de afișaj îmi zicea că i-a cerut un zăbăuc de generație Z să-i înființeze o firmă și zăbăucu’ era tare mirat când i se spunea că o firmă nu-i o firmă. Și asta e rezultatul scăderii focalizării educaționale pe discipline tehnice – din păcate, eu mă tem c-am rămas cu mai multe pentru viață din materiile de TLE, PDT și RM (rezistența materialelor) decât o să rămână fiu-meu din dezvoltare personală, educație pentru mediu sau religie.

Anyway … back to the future … mulți numesc A.I. niște subrutine ultra-simpliste dar frumos împachetate, deși cam tot ce se bazează pe motorul de inferență nu poate fi deloc numit A.I., iar sistemele bazate pe conceptul motorului de inferență sunt 99,99 % din cele existente, inclusiv majoritatea sistemelor de digitalizare a imaginii analogice (identificare vizuală, audio, spectrală, diferențiere, etc.). Deci, strict referitor la problema pusă de tine, eu nu cred că trebuie supra-reguli specifice pentru sistemele de motor de inferență, care nu fac decât să execute niște instrucțiuni, și implicit li se pot acorda funcții de no-man-in-the-loop. Pentru chestiile gen ChatGPT lucrurile sunt mai încurcat de analizat (mi-am zis să chinui serverul lor cu sarcini mai sofisticate dar n-am avut timp – pentru sarcini simple mi-a plăcut dar nu m-a dat pe spate), dar serverul ChatGPT pus la un loc ar însemna vreo 10000 de calculatoare, adică asta ar însemna după legea clasică a lui Moore o evoluție către un sistem mic stand-alone de 1,5 ani x 14 = 21 ani … Mai e ceva pân-atunci … nu mult, da’ mai e …

Fără a fi nici pe departe Hari Seldon, mă hazardez să fac și eu o predicție. Mă bazez pe natura umană. Aceasta rasă este predatorul suprem, crud și nemilos cu semenii săi și natura înconjurătoare. Nu va ceda niciodată controlul. Într-un fel sau altul va avea ultimul cuvânt de spus, deoarece are instinct de conservare și se teme să dea mână liberă unor entități raționale autonome pe motiv de Skynet.

P.S. Mi-a plăcut articolul, este printre putinele pe care le-am citit nu o singură dată.

hmm, cred ca aici este problema…poate sa cedeze controlul fara a fi neaparat constient de acest lucru…tocmai lacomia si prostia pot face acest lucru posibil.

Lacomia si prostia… iata doua caracteristici profund umane. 🙂

Deja corporatiile mari folosesc diferite IA-uri, aflate la diferite niveluri de dezvoltare – vezi Google, FB, Amazon, Tesla, etc.

AI-urile in scopuri militare vor elimina orice concept de etica … parerea mea.

Mai ales cele de pe dronele aero, care nu vor sta pe ginduri sau calcula prea mult daca trebuie sa doboare sau nu un avion identificat ca inamic. Deocamdata se testeaza intensiv, odata cu aparitia avioanelor de lupta de gen.5 sau 6, vor aparea si dronele aferente, ca si „wing-man”, gata sa fie sacrificata daca e nevoie de catre operatorul uman.

Totul tine de cit de buna va fi programarea initiala si cum va putea AI-ul sa evolueze, daca i se vor impune limite de invatare. Daca nu, va fi doar un simplu robot, programat sa faca X lucruri, fara capacitate de invatare – dar atunci nu mai e AI in adevaratul sens al cuvintului.

Noi particule/elemente si noi stari ale materiei/elementelor/atomilor/moleculelor au fost descoperite in experimente pornite de la „idei” de AI si observate tot de AI, datorita inovatiei in acest domeniu.

Si cum orice noua inovatie are parti bune si parti rele, si aici, pentru AI, dezvoltarea ulterioara va aduce atit beneficii cit si neplaceri – fie ca ne place, fie ca nu.

Si folosirea AI-ului la producere de noi arme sau folosit in scopuri militare, este deja posibila, depinde de noi cit de mult vrem sa ii dam friu liber dezvoltarii sau cit de ingradita sa fie.

Robotii si AI nu au sentimente, nu au constiinta de sine, nu stiu ce loc ocupa in univers, nu cred in nimic, nu sint subordonati decit propriului program si programarii initiale.

Robotii gen „Terminator” au un singur scop, sa ucida orice fiinta umana.

Nu cred ca se vor dezvolta roboti de acest gen, pe baza de Ai, in armata ai nevoie de oameni/roboti, care sa indeplineasca ordinele fara ezitare si fara a se gindi prea mult, deci potentialul de dezvoltare la un AI militar o sa fie stric redus la ceeace ce e necesar sa faca – asta e opinia mea personala.

La fel, un AI dintr-o drona de lupta, care sa insoteasca un avion de vinatoare propriu-zis, nu fa fi foarte „destept”, va face ceeace i se va ordona si cam atit. Nu va avea initiative … deci va fi un robot mai dezvoltat.

In momentul in care AI va „anticipa” un eveniment, atunci putem vorbi de o dezvoltare semnificativa in acest domeniu, cel mai simplu exemplu fiind cel cu soferul care observa o minge ca trece prin fata lui, la citiva metri departare, si constientizeaza ca e posibil ca un copil sa apara in fuga dupa ea, si reduce viteza.

Tesla nu stie de chestii din astea, vezi de ce se intimpla accidente cu Tesla.

O fi AI-ul lor dezvoltat, dar e departe de ce ar trebui sa fie o masina autonoma.

Exista chiar filmulete si marturii ale inginerilor de la Tesla prin care se arata ca asa-zisul self-driving contine pasaje trucate si ca masinile nu ar fi chiar asa de sigure in acest mod, putind interveni multe lucruri care au scapat programarii – vezi si numarul de accidente de acest fel, in care functia self-driving nu a functionat cum trebuie.

Deci e loc de mai bine in dezvoltarea AI-ului, dar pina la asa-zisa stare de self-awareness mai e cale lunga. Daca nu se implementeaza f.bine de la inceput legile si algoritmii de programare, ne putem trezi cu mutanti-AI, scapati de sub control.

@Tony. Mă tem că ai o perspectivă puțin cam romanțată asupra naturii umane. Natura umană înseamnă cogniție + afect + voliție + aleator. Te rog să mă crezi că noi, oamenii, nu suntem atât de diferiți de fierotenii în domeniul cogniției, singurul lucru care este comparat de voi. Ca să joci șah nu ai nevoie de afect și voliție decât pentru a maximiza randamentul cogniției. Poți să ai un coeficient ELO de 2800 da’ să te umfle râsu’ când se-mpiedică fi-tu’ și-i iese bulionu’ pe nas. De fapt, ca să obțină asemenea randamente, mai toți marii șahiști sunt cam ciudăței bine de tot și la foarte mulți performanța se explică prin disocierea parțială a cogniției de celelalte din sindromul Asperger înalt funcțional. Cam la fel și robotu’ – nu are nevoie de atributele umane de sentimente, empatie, etc. ca să execute sarcini pur matematice, indiferent cât de complexe. Ciudat e că s-a descoperit acum că fără afect decizia nu mai e intuitivă, ci doar probabilistică, iar fără voliție un sistem nu poate avea comportament neg-entropic …

Mai pe scurt, noțiunea de inteligență se definește prin capacitatea unui sistem de a evolua în sensul modificării mecanismelor de raționament pentru adecvarea la scop. Chiar dacă nu are emoții, un sistem poate fi numit A.I. dacă prezintă o evoluție a mecanismelor interne de raționament, că dacă rămâne doar pe setul de algoritmi inițial sau chiar dobândit prin descărcare din exterior … rămâne la stadiul de fierotenie. In reverso, un om rămâne om, chiar unul foarte empatic, și dacă nu se smiorcăie la telenovele mexicane (că la ălea turcești sau indiene îți trebuie multe chestii în lipsă ca să verși lacrimi).

Prin anii 70 Bobby Fischer declara ca poate invinge computerul, chiar dandu-i handicap dama si doua ture !

In 1997, Garry Kasparov era invins de deep blue(greu sa scriu cu majuscule!) cu 3,5/2,5 !

In 2016 , Lee Sedol era invins de alphago !

Daca infrangerea campionului mondial de sah era previzibila , urmarind performantele diferitelor programe concomitent cu viteza microprocesoarelor, pt mine , infrangerea campionului de go fost un tsunami ! Numarul combinatiilor posibile in go este cu foarte mult peste cel al combinatiilor sahiste. In plus, aspectul strategic imi parea in jocul de go superior celui tactic: de ex in sah, cu un avantaj material important, prin simplificari(schimburi de piese), un elo 2000 poate invinge campionul mondial (elo 2800) sau un program puternic de peste elo 3000. Si in go exista notiunea de handicap, dar diferenta intre un jucator mediu si un campion (un dan) imi pare substantiala .

Am fost curios sa aflu cum a fost posibil asa ceva.

Daca deep blue se baza pe o biblioteca de date fantastica, corelata cu o viteza de calcul fenomenala, alpha go a invatat jocul si s-a perfectionat jucand cu…el insusi !

Si aici m-a luat cu frig…

Intre timp, programul alphago a fost adaptat jocului de sah si s-a intamplat ceva !

Pt pasionatii de sah, si nu numai, partida dintre alphazero si programul campion mondial la acel moment (o versiune Stockfish) il aduce la viata pe…Morphy !

https://www.youtube.com/watch?v=nPexHaFL1uo&t=25s

P.S. Mi se pare de cosmar o tabla cu o arma , ruland un program din asta…

un salt semnificativ in calitate in ultima decada a fost cel cu go, intr-adevar ; un articol care explica contextul:

https://www.scientificamerican.com/article/computer-beats-go-champion-for-first-time/

ca unul care am jucat ambele jocuri la nivel amator o perioada, ambele medii (sah, go) sunt medii limitate, de pilda n-au fog of war

chiar daca saltul in calitate mai e posibil si la nivelul tehnologic actual e nevoie de putere de calcul/stocare/energie mult mai mare…nivelul urmator nu e asa aproape

ne e dificil sa inlocuim gazul cu electricitate, darmite sa rulam multe computere puternice in acelasi timp. va fi o revolutie, se vad zorii dar mai e pana la rasarit (computerele cuantice)

eu nu cred ca va exista nici o dilema morala de nici o parte pentru a face astfel de arme. pana la urma sunt altele interzise acum si tot sunt detinute de unele tari, chiar si de cele democratice (clusters, biologice).

pentru situatia armelor care scapa de sub controlul uman si sunt un pericol chiar si pentru detinator se poate instala un dispozitiv separat gen IFF care sa activeze autodistrugerea in cazul in care nu mai e sub control uman.sunt sigur ca se pot gasi multe solutii tehnice.

referitor la dezastre in aer, nu cred ca tine de AI, pana la urma un aparat asa complex poate actiona singur si in afara controlului uman si din probleme de proiectare, software, etc. la tragedia de la Balotesti asa a fost, tractiunea s-a modificat din cauza unei erori de proiectare si copilotul singur n-a fost in stare sa mai indrepte ceva. Ai zis si de MAX, acolo idem, probleme de proiectare; chiar vorbeam imediat dupa accidente cu un pilot civil care zbura chiar Boeing (nu MAX) si zicea ca erau intr-o masura de evitat daca pilotul era mai experimentat si ca sunt unii piloti care nu sunt atat de bine instruiti si nici in situatii cu probleme nu ies din litera procedurilor pentru ca ori nu stiu altceva ori le e frica de companiile de asigurari.

Deci asta nu e numai treaba de AI si cred ca e un mare hype pe chestia asta. Cred insa ca nu va exista nici un salt tehnologic in urmatorii 20 de ani. Chat-ul ala de e toata lumea entuziasmata o sa ne imbunatateasca viata cum ne-a imbunatatit-o google ca motor de cautare dar nu ne va lua locul si nici nu va gandi in locul nostru, cel mult va pune intr-o forma mai atractiva ce au gandit altii; ma uitam la colegii mei la ce l-au folosit, toate au fost exclusiv chestiuni cosmetice sau intrebari enciclopedice si nu avea nici cea mai mica capacitate de adaptare;

nu s-a ajuns la nivelul de masina ganditoare la care sa ne punem problema ca autonomia ei va iesi de sub controlul nostru si nici nu se va intampla prea curand.

pentru cine e insa interesat sa citeasca ceva mai academic pe tema asta recomand aceste doua eseuri:

https://plato.stanford.edu/entries/artificial-intelligence/

https://plato.stanford.edu/entries/computational-mind/#ArtInt

ganditi-va ca masinile inlocuiesc oameni deja de 50 ani, butonul de la lift -> liftier, robot industrial -> muncitor pe banda. unele au un grad de autonomie deja in task-urile lor si se va continua pe aceasta cale insa cel mult augmenteaza gandirea umana nu o inlocuiesc

deci raportarea la computerele sahisti (8×8) si jucatori de go (19×19) nu da semnalul unui inlocuiri a mintii umane cu una artificiala; doar pentru dublarea (s’un pic) spatiului de joc a fost nevoie de un efort considerabil, va dati seama ca pentru lumea reala unde pot aparea mii de variabile intr-un minut cam ce sanse au computerele alea de sahisti.

asa ca nu, nu ma sperie AI-ul, cred ca tot un instrument ca si celelalte arme si nu cred ca vor exista, fundamental vorbind, probleme de etica si moralitate cu adevarat noi. Noi, oamenii, in sine nu creem ci descoperim natura si ne adaptam la ea. Tehnica nu iese din acest pattern.

distractie placuta 🙂

https://i.redd.it/j2j4mpad7uca1.jpg

Gary Kasparov la acel moment încă putea să-l bată pe Deep Blue, dar cred că s-a lăsat bătut. A câștigat o partidă jucând pozițional, arătând cum trebuie să joci contra computerului, apoi a pierdut ultima partidă în doar 19 mutări jucând tactic, arătând cum nu trebuie să joci contra computerului. Asta a fost clar pentru cine știe șah, chiar dacă Kasparov n-a declarat nimic în acest sens. Kasparov nu pierde în 19 mutări la nimeni. Apărarea Caro-Kann pe care a jucat-o Kasparov, acea variantă foarte la modă atunci cu 4…Cd7 în loc de Nf5, era extrem de periculoasă, chiar dacă ar fi jucat-o împotriva unui jucător de top de atac, dar contra unui computer s-a dovedit sinucidere curată, și asta pentru că computerul poate să calculeze mult, repede, și corect. Nici un șahist de top n-ar fi jucat acea variantă de Caro-Kann contra computerului, alegerea lui Kasparov n-a avut sens, doar dacă vroia să piardă forțat. Am impresia că după partida asta acțiunile IBM au crescut mult 🙂 iar Kasparov a câștigat și el bine, și toată lumea a fost mulțumită.

În ziua de azi AI AlphaZero a învățat într-o singură șahul studiind o bază de date cu partide, după care l-au pus să joace cu cel mai bun program specializat de șah și l-a cam făcut praf. Culmea este că AlphaZero nu calculează tot atât cât Stockfish, dar face predicții în baza statisticilor. De pildă dacă statistica îi spune că are mai multe șanse să câștige dacă atacă cu pionul la g4 decât cu h4, atunci AI joacă g4. Asta e uluitor, nu că poate să calculeze, ci că face estimări foarte bune. Actualmente programele de șah de top sunt peste campionul mondial.

Am jucat de multe ori contra computerului, și ce pot spune este că dacă NU GREȘEȘTI, îi va fi greu să te bată. Dacă însă comiți greșeli, computerul nu prea face asta, și începi să pierzi puțin câte puțin. Am bătut odată programul ChessMaster Grandmaster 2950 Elo (!) jucând pozițional la țăcăneală, iar odată l-am rupt cu bătaia într-o partidă tactică în care am sacrificat piese. Deci se poate. În sens invers n-are rost să spun de câte ori am pierdut 🙂

Ce pot să spun e că în utlimii ani programele de Inteligență Artificială au impresionat în șah, au performanțe de te lasă cu gura căscată, au devenit etalonul la care lumea se raportează.

Pot fi folosite în luptă? Realitatea conține mult mai multe variabile decât jocul de șah. Probabil că o dronă ghidată de AI își poate schimba profilul misiunii dacă senzorii detectează o oportunitate, iar calculele îi arată că poate provoca daune mai mari inamicului dacă face cu totul altceva decât planul pe care l-a încărcat inițial. Dar există acolo în program o linie care zice ”while civil =1 do nothing”? Sau în acoladă e un comentariu care zice cinic ”pierderile colaterale sunt acceptabile”? Bizar…

Referitor la “Probabil că o dronă ghidată de AI își poate schimba profilul misiunii dacă senzorii detectează o oportunitate, iar calculele îi arată că poate provoca daune mai mari inamicului dacă face cu totul altceva decât planul pe care l-a încărcat inițial.”

O astfel de arma este LRASM: https://www.rumaniamilitary.ro/buletin-naval-lrasm

multumesc pentru comentariu si completarile foarte interesante. nu imi mai aduc aminte asa in amanunt, nu mai joc sah/go de vreo 10 ani altfel decat casual cu calculatorul

insa atunci aveam un coleg care era maestru si se ducea la turnee; evident ca se distra cu mine, juca fara sa se uite la tabla si ma batea lejer, era si demoralizant la un moment dat :)) probabil ar fi ajuns departe daca nu bea atat de mult.

da, cam asta voiam sa evidentiez si eu, sahul este totusi un joc limitat ca numar de combinatii si pasul la go a fost foarte mare, darmite la situatii reale; pana si la masinile care se conduc singure exista un mediu pana la urma limitat (hartile de strazi) si reglementat, ceea ce intr-un scenariu de razboi nu prea exista si unde intervine disimularea, simularea unei miscari, camuflaj, in general inselatoria ceea ce cum spuneai nu prea e bina primit de AI (exemplul tau cu jocul la tacaneala sau sacrificiile pentru avantaj tactic).

As dori sa impartasesc optimismul dvs si al @omul-ui…Nu voi intra in consideratii sahistice cu dvs, prefer confruntarile pe esichier ?, dar informez chibitii ca la ora actuala, programele de sah spulbera pe cei mai buni jucatori umani:

https://www.google.be/search?q=alphazero+vs+hikaru&ie=UTF-8&oe=#fpstate=ive&vld=cid:1585c1c1,vid:aP_VNlKLAXg

Pesimismul meu vine din uimirea aproape mistica pe care mi-o provoaca performantele simulatoarelor , pilotilor automati si al acestor programe care se autoperfectioneaza ruland. Nu mai vorbesc de senzori sau de acuratetea legaturilor prin sateliti…

Sunt un profan in domeniu IA, dar nu pot sa nu-mi imaginez combinatia acestora cu un robot ucigas…

Jucând șah contra computerului pot spune că E VICLEAN și îți întinde momeli, iar dacă ți se pare că vezi o mutare câștigătoare facilă, aia e o capcană, pentru că în realitate computerul nu prea face greșeli, iar dacă le face sunt mici și sunt greu de exploatat. Deci umblă cu cioace ieftine să te păcălească.

Aceste programe de șah nu numai că joci cu ele, dar îți pot oferi în timp real și o evaluare a poziției, în baza calculelor lui, care evaluează egalitatea drept 0, iar avantajul de o parte sau de alta de genul 0,1 (mic avantaj pentru alb) 1 (avantaj pentru alb), -2(mare avantaj pentru negru) etc. Ei bine dacă joci rezonabil și ți egalitatea poziției la 0, dacă te iei după computer să joci mutările pe care el ți le recomandă împotriva lui însuși, începi și pierzi puțin câte puțin. De pildă îți recomandă o mutare evaluând poziția la 0,1 pentru tine. După 5 mutări ajungi la -0,5 pentru el. Parșiv. Dacă joci o mutare pe care el ți-o evaluează la -0,1 adică mic avantaj pentru el, peste 5 mutări vezi că obți de fapt avantaj 0,2 pentru tine. Asta a fost testat de mine personal. Ce vreau să zic este că evaluările computerului nu sunt întotdeauna cele mai corecte. Dar asta numai la egalitate sau la avantaje mici. Nu știu dacă e programat să te păcălească, sau chiar are probleme în evaluarea pozițiilor aproximativ egale. Și am văzut asta chiar jucând cu Stockfish, cel mai bun program specializat de șah (nu AI). Deci sentimentul e că programul nu joacă cinstit și în situațiile de egalitate încearcă să te păcălească cumva pentru a obține avantaj. La fel și când pierde, îți întinde tot felul de capcane. În șah computerul are un caracter de rahat 🙂 de multe ori îți vine să-l iei la palme.

Deci spre deosebire de om care poate face uneori greșeli, programul nu are sincope grave, iar dacă îți dă impresia că a a greșit, aia e o capcană. Sunt șanse mari ca acest caracter viclean al computerului să se păstreze și în cazul unui program AI pentru armată sau servicii.

M-ati convins, nu aveti nici o legatura cu sahul ! Incercati mai bine sa scrieti SF, pareti a avea imaginatie ! No offence ! ?

In cartea „Soarele gol” a lui Isaac Asimov, un robot ucide un om prin intermediul altui robot.

Elijah Baley este trimis sa investigheze si … va las placerea sa cititi cartea.

Deci legea a 3-a e incalcata.

intr-adevar excelenta cartea…cam tot ce a scris omul asta merita citit chiar si in ziua de azi.

AI-ul este un termen impropriu. bun de folosit doar ca PR. buna ocazie mai ales ca sa se obisnuiasca lumea cu el 🙂

Totusi pare cam inevitabila si aparitia lui…aici sunt cam de acord si cu ce spune mihais. in prima postare. Acum ca cutia pandorei s-a cam deschis nu cred ca mai poate fi monitorizat sau oprit.

Nu este ceva ce poate fi limitat, controlat ca tehnologia nucleara…si cum dezvoltaarea si implementarea in diverse configuratii si scopuri pare realmente infinita…

so cum cam toata lumea vrea o portie din acesta noua placinta poate ca the Great Filter nu pare chiar asa imposibil odata ce masinile capata acces la date in mod nelimitat si mai ales in timp real.

Legile fizici din ce stiu nu par sa excluda complet posibilitatea ca intr-o buna zi constiinta de care facem noi atat caz sa apara chiar si la masini…pana la urma. in esenta si noi suntem tot un fel masini…chiar daca de alt tip.

Poate ar trebui inceput articolul cu sublinierea diferentelor intre AI, machine learning si

automation. Fara a intra prea mult in detalii (subiectul e vast) se poate sintetiza in felul urmator:

– AI un computer (unitate de procesare) care poate replica modul de gandire uman

– ML este procesul princ care computerul devine AI (in baza unor algoritmi, analizeaza datele puse la dispozitie si dezvolta propriile concluzii si rutine de „gandire”)

– automation: procesul de automatizare a deciziilor in baza unor reguli clare

De ce am vrut sa facem diferentierea? Pentru ca o drona (sau orice alt sistem, militar sau nu) poate fi autonom, fara a fi AI. Decolezi, zbori la punctul A, zbori la punctul B, tragi 3 rachete la coordonatele X:Y, zbori la punctul C, revi la baza, aterizezi. O drona urmand aceste reguli ar fi cat se poate de autonoma, fara urma de AI.

O sa il contrzic un pic pe colegul ADR: nici softul de pe masinile tesla nu e AI. Te asigur ca 1000 de masini puse in fata aceluiasi scenariu ar avea aceleasi reactii (nu discutam aici de cazul in care o masina nu avut toti senzorii in ordine).

Un AI ar fi capabil sa incalce regulile, daca analiza lui arata ca aceasta actiune ar avea rezultate mai bune decat respectarea lor (exact ca un om). De ex daca am avea un AI pe o masina, in fata caruia apar brusc un om, intr-o zona cu linie continua, AI-ul ar lua probabil decizia sa treaca peste linia continua, incalcand regulile, pentru ca aceasta actiune ar salva viata persoanei din fata masini (efectele pozitive sunt mai mari decat efectele negative). Din pacate a fost o situatie reala oarecum similara acum cativa ani, cand o masina de test a google parca a omorat o femeie care s-a angajat in traversare neregulamentara exact in fata masini. Masina a incercat sa franeze, dar nu a mai fost timp (era si o persoana la volan, dar era cu ochii in telefon).

Daca se pleaca de la ideea ca un AI copiaza modelul de gandire umana, parca as prefera un AI la butoane decat un om, pentru ca ai avea acelasi proces de luare a deciziilor dar fara miniusurile umane: AI-ul nu va fi distras, obosit, va putea folosii intotdeauna maximul de informatii primite de la senzori.

PS fain articol, ca de obicei

salve, ai mare dreptate, este confuzie foarte mare intre AI si ML, de aia am scris „gen autopilot Tesla”. Legat de process automation, utilizat frecvent, nu vad asta ca o solutie de ghidare vehicul aerian, asta poate daca nu vrei sa functionezi super basic gen autopilot + cateva blocuri de decizie in puncte geocode definite, timing etc. Dar in acceptiunea de navigare dinamiza devine trivial conceptul. As spune ca asa functioneaza autopilotul actual al dronelor, are niscai if-uri pe acolo, daca pierde semnal, daca nu mai are combustibil ..blabla, face un get geocode default si revine, iar la aterizare pe o pista predefinita uzual te poti sincroniza destul de simplu cu timing/geocode/viteza/vant daca ai mai facut asta.

Am si eu pe masina autopilot adaptiv care este asa cum spui doar o automatizare, isi ia fault rapid daca nu mai vede o dunga sau daca masina din fata dispare brusc. Dar din ce am vazut la Tesla (pe net ca nu am 🙂 nu pare sa fie asa de simplu, are o componenta mare de date dinamice pe care le evalueaza si ia decizii, este imposibil ca cineva sa scrie cod sa trateze toate aceste scenarii. As zice mai degraba ca este un ML care se hraneste mereu cu datele device-urilor din retea (sunt legate la net mereu) si pe masura ce algoritmul de predictie evolueaza da patch-uri catre device-uri. E doar o supozitie, dar si eu spun ca nu este un AI in adevaratul sens al cuvantului, fara sa ne gandim la decizii si sa luam numai ca-i lipseste abilitatea de planificare, care sigur nu o are.

Legat de viitor, am aceeasi vedere legata de o masina la butoane, dar pentru procese de business unde pe un singur pattern poate performa mult peste nivelul uman. Am avut contact cu ML la un proiect legat de escaladari cand am descoperit ca datele default luate de la cei mai buni useri au fost mult contrazise de predictie, asta fiind si realitatea ulterioara.

In schimb nu mi-as dori sa decida statistic cazuri ce tin de fiinta umana, iau doar ca eg. daca ar evalua un bolnav, masina va calcula statistic pe n cazuri ca e gata, dar in realitate variatia umana o poate contrazice. Da, dupa acel caz de fail isi va imbunatati predictia, dar cazul e consumat.

Legat de Tesla, nici eu nu am, dar ma îndoiesc sincer ca fiecare masina e dotata cu un computer suficient de performant pentru a rula un AI. Tot pe un set de reguli fixe se bazează. PoSibiu ca în procesul de definire și codare a regulilor echipa de dezvoltaee sa fie ajutata de un AI, măcar pe partea de analiza a imensei cantități de date colectate de la mașini.

Mai interesant mi se pare ce spui în ultimul paragraf, pentru ca în opinia mea, faci o greșeală destul de comuna (te rog nu ma înțelege greșit, în nici un caz nu zic asta ca să jignesc), și anume ca un AI își va baza deciziile exclusiv pe istoric și statistici, ceea ce e greșit. Cel mai bun contraexemplu este Alphago, menționat mai sus de cineva. Mutarea aceea devenita celebra nu s-a bazat pe nici un fel de statistica, a fost complet noua, inventata de AI în urma unui lung proces de învățare (a jucat foarte multe jocuri cu el insusi).

Ca sa revenim un pic mai la subiect, nu sunt sigur dacă problema e de moralitate ( e mai moral dacă decizia de elimina o tinta e luata de un om fata de un AI, chiar dacă datele avute ka dispoziție sunt aceleasi?). Cred ca reticenta vine mai degraba de la ideea de a ceda controlul unui factor de decizie non-uman (implicit inferior). Nu e ca și cum majoritatea liderilor politici (sau militari) dau pe afara de etica sau moralitate.

Va scriu aici amandurora, ca e mai simplu 🙂

@Mihai In primul rand, multumesc pentru completari!

Ai facut o observatie extrem de buna, dpmdv: „Pentru ca o drona (sau orice alt sistem, militar sau nu) poate fi autonom, fara a fi AI.” I-am raspuns lui mihais mai sus, exista suspiciuni ca o drona functionand in mod autonom a omorat in Libia. Kargu, drona banuita, pare a fi o munitie kamikaze. Cel mai probabil, toate munitiile kamikaze au aceasta posibilitate multumita camerelor performante si algoritmului de recunoastere (model NSM) a ceea ce vede (probabil in baza unei biblioteci).

Revenind, discutia nu este doar despre AI, discutia este despre armele autonome si capacitatea lor de a ucide fara supervizare umana.

Astfel ajungem la afirmatia lui @ADR: „Am si eu pe masina autopilot adaptiv care este asa cum spui doar o automatizare, isi ia fault rapid daca nu mai vede o dunga sau daca masina din fata dispare brusc.”

Ca si pilotul automat adaptiv, si arma autonoma se bazeaza pe senzori. Iar senzorii se pot defecta (de asta am dat exemplele din aviatie) sau pot furniza informatii gresite. Un radar poate functiona deficitar in conditii meteorologice grele, la fel ca o camera cu termoviziune. Un tanc seamana sau poate fi facut sa semene cu altul etc samd

Ca idee, am refuzat sa-mi iau pilot automat adaptiv sau pachetul ala cu n-spe mii de avertizari – unghi mort, pietoni etc pentru simplul motiv ca senzorii nu sunt inca suficient de performanti si genereaza extrem de multe alarme false. Vorba lui ADR, dispare semnalizarea benzilor de pe caldaram si s-a terminat. Si cate benzi nu dispar din senin de pe caldaramul autohton…

Si mai e si o chestiune de responsabilitate. Uite, pe Milosevici l-au condamnat etc samd. Dar ce faci daca Milosevici folosea un robot autonom pentru toate nenorocirile alea? Nu e cel mai bun exemplu, dar cred ca se intelege ce vreau sa spun…

legat de autopilotul adaptiv, are o chestie super naspa daca nu eram atent ma faceam praf de 2 ori cu toata familia!!!

Pe autostrada de regula cand se lucreaza scot glisiera si trec traficul pe cealalta banda. Acolo traseaza niste dungi galbene in viraj. Dupa ce refac si dau drumul la trafic idiotii NU sterg dungile alea curbe care duc direct in glisiera.

Autopilotul vede curba si vrea sa o urmeze adica direct in glisiera. Si nu vireaza progresiv, pur si simplu reactioneaza violent. Noroc ca eram pe banda 1, daca eram pe 2 ma loveam.

Aviz celor care mai au asa ceva!!

Asa mi-am dat seama e ceva empiric, nu a stiut sa interpreteze ca mai exista inca o dunga si sa dezactiveze macar.

chiar daca exista marketing, domeniul este foarte nou pentru simplul motiv ca noi inca nu ne intelegem pe noi ca masina,

Uite o chestie care o vad ca risk blocant in dezvoltarea unui AI.

Orice animal are un soft de baza care ii spune sa supravietuiasca, adica resurse de energie si protectie. Lista de task-uri facute de animale domestice sunt ca si prioritate dupa setarea default din nastere pentru supravietuire. Omul care este cea mai evoluata fiinta mental are aceeasi setare, noi o numim instinct de supravietuire. Unii specialisti spun ca inconstient noi cautam lucruri negative de mult mai multe ori ca cele pozitive, din logica simpla ca negativul inseamna nevoie de conservare, adica prioritate 0. De aici vezi si teoriile conspirationiste care prind asa de bine (inclusiv pe aici), sunt la baza hrana pentru creierul nostru care e pe search nonstop. BTW, de aia e foarte periculoasa dezinformarea, creierul daca primeste 100 de mesaje bune la proceseaza cu o prioritate, dar daca primeste unul singur negativ imediat il compara cu regula prioritara de supravietuire.

Teoretic, daca vei clona modul de functionare a gandirii umane este inevitabil ca in procesul de self learning un AI sa nu ajunga sa-si puna intrebarea asta si sa o trateze prioritar. In acel moment AI ul va trata lista de task-uri primite ca si prioritate secundara si sa reactioneze prioritar pe self defence. Riscul e urias sa ne creem singuri un inamic superior.

ce este invatarea la nivel elementar? o stocare de date pe system relational + sortare pe rata de success + corectie dinamica ratata de succes + arhivare storage (ne aducem aminte) + clean up date nerelevante (uitam). Pana aici face si un ML. De regula o masina lucreaza pe false/true, omul stie false/true/irrelevant, cand e irrelevant baga in loop procesul si incepe sa-si largeasca numarul de parametrii in pe care ii baga in evaluare, pana cand primeste raspunsul relevant. Cam asta este esenta cunosterii, cand nu avem raspunsuri multumitoare exploram si cautam pana cand obtinem ce vrem, dupa care stocam si o.luam de la capat.

Un ML nu poate face asa ceva (sau cel putin nu am vazut cat am lucrat) acolo variabilele in erau declarate si chiar daca am fi bagat un loop sa aduca niste variabile mai extinse era tot ceva predefinit.

Aici vad rolul AI ului, intra in loop si exploreaza/stocheaza/ analizeaza pana obtine un procent de success acceptabil, daca facut evaluri el pe el e normal sa-si fi dezvoltat solutii proprii atat timp cat era liber la mutari pe o tabla.

Dar, indiferent cine cum si in ce fel, acea adpatare de care spui are la baza tot o evaluare statistica, fix asa functionam si noi.

Sunt de acord pana la un punct, dar ce vreau sa spun ca analiza statistica a acelorași date poate duce la rezultate și interpretări diferite. Un exemplu grăitor (și oarecum haios) este povestea lui Abreham Wald, cel care a „salvat avioanele aliate” în WWII. Pe scurt, când US a vrut sa îmbunătățească rata de supraviețuire a avioanelor și a inceput sa analizeze părțile avioanele întoarse din misiuni. Statistica a arătat ca cele mai lovite zone erau în principal extremitățile (aripile, cozile). S-a făcut un planpentru a îmbunătăți protecția acestor zone dar calculele arătau ca avioanele protejate astfel pierdeau mult din manevrabilitate și raza de acțiune. Dilema a fost rezolvata de Wald, care a arătat ca ca analiza a fost făcută pe avioanele care supraviețuiască misiunilor. Concluzia lui a fost diametral opusa: îmbunătățiți protecția în jurul carlingii și sl motorului. Deși contestata, concluzia a fost pana la urma aplicata, iar rata de supraviețuire a a avioanelor a crescut.

De asta zic ca un AI ar putea veni cu soluții neașteptate la unele probleme, deci contribuția ar fi benefica până la un punct. Iar discuțiile legate de decizii majore care ar duce la extincția umanității cred ca sunt un pic exagerate, nici acum nu decide o singură persoană în problemele mari (declarare război,lansări de nucleare etc). Dar pentru decizii cu impact limitat, gen un avion sau un tanc dotat cu AI, probabil ca vom ajunge acolo mai devreme sau mai tarziu.

Salut,

Oricum la asta se va ajunge, la autonomie și asta, cu certitudine. Amânăm inevitabilul și încercăm să părem „mai cataloci de cât Papa”.

„Amânăm inevitabilul și încercăm să părem „mai cataloci de cât Papa”.”

Ii zice dezbatere… 🙂 E un exercitiu democratic, stii? 🙂

Hop si aurolacu’ la arat. Multumiri lui Nicolae pentru articol, intradevar un subiect deosebit de interesant. De mult asteptam un articol pe tema asta si uite dorinta mi-a fost indeplinita (Nu am vorbit direct cu RM nci cu Nicolae, am folosit telepatia). Subiectul e de mare actualitate si asta din cauze multiple. Robotii ucigasi (pe pamant, pe apa sau in aer) sunt folositi pentru prima data pe scara larga in Ucraina (in ciuda faptului ca multi specialisti afirma ca seamana cu WW1 (seamana dar numai pana la un punct). Ambele parti beligerante utilizeaza robotica pe terenul de lupta, ultimul anunt in domeniu asta a fost facut de rusi care au anuntat ca vor introduce robotii vanatori de tancuri (ramane de vazut daca or sa o si faca in realitate). Toate tarile lucreaza intens in domeniul asta. Cei mai avansati par a fi USA, South Korea si Israelul. Dar asa cum e mentionat in articol exista o mare dilema morala. Deocamdata fara AI sau numai cu AI limitat (sud coreeni au bagat AI in cainele robot si rezultatele au fost mai mult decat spectaculoase) In paranteza fie spus sud coreeeni sunt foarte criticati de lumea stiintifica (academica) de foarte multi ani in ceea ce priveste robotii ucigasi si sincer sa fiu nu inteleg de ce. Toti fac la fel.

Si cum o imagine valoreaza mai mult decat o mie de cuvinte iata doar trei exemple elocvente dupa parerea mea :

Primul exemplu din Rusia care a facut ceva progrese in domeniu se vede evolutia de la video la celalalt.

https://www.youtube.com/watch?v=P_CDu1hYXxk

https://www.youtube.com/watch?v=HTPIED6jUdU

Al doilea exemplu din US. Faceti cunostinta cu Atlas care a ajuns la pubertate si un dogbot.

https://www.youtube.com/watch?v=YlDLwTsRHtU

https://www.youtube.com/watch?v=tF4DML7FIWk

Al treilea exemplu vine din China care si-a trimis déjà robotii de lupta in zona de disputa cu India.

https://www.youtube.com/watch?v=Qz6F6lznT5Q

https://www.youtube.com/watch?v=afPbga9ooX4

Si o mica parodie si nu prea referitor la AI si cele trei legi ale roboticii.

https://www.youtube.com/watch?v=y3RIHnK0_NE

Vizionare placuta si un sfarsit de saptamana cat mai linistit.

Sa profitam de ele ca nu se stie cate mai avem sansa sa prindem.

PS

In teoria conspiratiei exista niste roboti care ar fi omorat deja fiinte umane din senin din iarba verde.

Am inceput sa urmaresc un serial rusesc pe Netflix pe tema asta, E bine realizat, abia astept sa vad al doilea episod. Ma captivat. Holywood style.

PS la S

Tinerii nostri roboticieni sunt printre cei mai buni din lume. Robotii lor fac ravagii in competitii cu toate ca nu au sustinere, nu au fonduri, nu au sponsorizari decat mici si timide. Probabil ca vor pleca spre alte meleaguri. Asta e, sa multumim din inima partidului.

Autonomous mode of loitering munitions, „search and destruction”, „search and the collection of information”, there is. Elements of Artificial Intelligence advanced is rooted in neural networks, pattern recognition and even „training”.

Very good example, thanks!

bingo! 0 trolli pana acum. M-au mancat degetele sa scriu la un moment dat ceva legat de (in)abilitatea marelui popor in tehnologie, cel mai mare calculator (ca si masa 🙂 etc. Chiar eram curios daca se agata de orice sau intra doar pe articole targetate.

Bun nu zic ca nu e buna si tehnologia IA da sa fie lasata de capu ei , nu prea merge exista sanse sa devina distructiva pentru creator asa ca trebuie sa aibe un minim de siguranta / control un buton Off/On in caz ca o ia pe aratura

Of course … Unfortunately, the concept „human-in-the-loop” does not always work with time pressure. The Israeli nuclear button is not with the government, but with the military: – „blue folder” (files with retaliatory targets) Skynet actually, due to lack of desired strategic depth, alas…

Can A Machine Think?

https://www.youtube.com/watch?v=er_Jfprw6qY

(The Imitation Game)

Isaac Asimov , ce vremuri !Cartile traduse abia punea mina pe ele. La suprapret.

Interesant ce numar de cititori nascuti dupa 1990 au citit capodoprea SF.

Noroc cu idiotii de la PCR ce faceau legea si nu prea intelegeau treaba…..si mai aparea o carte faina.

Seria Robotii, Imperiul si Fundatia au fost recent republicate. Aviz amatorilor! 🙂

bun si captivant,o tema care ne invadeaza realitatea cu pasi de furnica dar siguri.

gen6 cu stolul de drone dupa el va fi ceva interesant in viitorului apropiat….

Forward-thinking nations are already preparing… https://esut.de/2023/02/meldungen/39925/elektronische-kampffuehrung-iai-und-mbda-deutschland-kooperieren/ (google) Filiala de electronice de apărare a Israel Aerospace Industries, ELTA Systems și MBDA Germania doresc să ofere soluții comune în domeniile războiului electronic la sol (EW) pentru apărarea aeriană și pentru instruirea EW în Germania și au încheiat un acord de cooperare în acest scop .

După cum scrie MBDA într-un comunicat de presă, soluțiile se bazează pe tehnologiile ELTA EW, cum ar fi familia de produse Scorpius. Potrivit informațiilor, acestea sunt sisteme EW bazate pe o tehnologie cunoscută sub numele de „Staring Multibeam AESA”. Scorpius este capabil să lupte cu mai multe amenințări în același timp, din direcții diferite și pe frecvențe diferite. Potrivit MBDA, acesta este primul sistem de acest tip din lume.

Tehno-optimism la greu si o groaza de previziuni fara acoperire. IA este sub oamenii ce o dezvolta si respectivii sunt departe de perfectiune. Automatizarile nu insesmna IA, puterea de procesare a datelor e una, analiza de tipare si predictia alta si alegerea unei decizii ce iese din algoritm este cu totul altceva. Robotii „in banda” au nevoie de mentenanta si reparatii iar masiniile autonome sunt un mare fail si asa o sa ramana pentru multa vreme. Senzorii, oricat de buni sunt, se pot defecta si capacitatea de calcul si tiparele pot sa fie date peste cap de multiple conditii din realitatea inconjuratoare. Vad ca sunt cativa ce viseaza la „Terminator”….in realitate nu putem face o baterie decenta la un secol dupa aparitia masinii electrice. Tehnologia este buna si ne usureaza viata dar nu cred ca e cazul sa o privim ca pe o icoana, nu de alta, dar sa nu ramanem ca aia ce nu puteau sa intre in casa ca au picat retelele electrice ori netul. Hai succes si sanatate, ma duc sa refac stocul de lemne la centrala ca sa creasca „codoiul” si sa ramana Terra verde.

hm .. ca de obicei supraestimati inteligenta si i scufundati cu ratiunea

Imulo dtragii Bizonuui este inteleigent, aduca sapiens , insa este rational cu .. intermitente!!!!

Sunt de acord cu georgel care la 00 februarie 2023 la 12:14 scris-a ca aceasta rasă este predatorul suprem, crud și nemilos cu semenii săi și natura înconjurătoare. Azi ne gandim daca sa mai prezervam cativa tigri…

Insda si mai rau … cei vare sunt cam preaocupati de IA suntem noi. ARIENII. SI noi, scuze suntem sămânța Dracului! Aroganta ariana nu are egal intre culturi! Desi mascata, inblanzita de crestinism, aceasta aroganta ne este in continuare definitorie dpv cultural. Cea mnai po[pulara poveste a noastra este cea a Eroului in luota cu destinul. Zeii olimpieni se supun sortii .. Eroul arian NU!

Si daca nu se supune sortii ci se razvrateste ..el lupta cu zeii.. da cu barda in zei, il face pe Zevs sa se bage sub tron (Belerofon) , moare blestemand zeii (Aias). Mai rau , in povestirele indiene un om sfant certandu-0se cu zaii creaza stele sudice …

ei bine si exact noi, arienii, suntem cam nemultuniti de rezultatul creatiunii in ce ne proveste. Asa ca ma dpori sa facem o IA care sa ce ? Cu mabilitate sa ne serveaasca preucm R Daneel Olivaw? Sa iabe grija de no precum masinile conti9nenstale sperate de Asimov (erveu dar contaminat de arianisme!).

Ntz noi vrem o zeitate care sa ni se supuna! Sa ni se supuna nopua , unor razvratiti ce dau cu barda-n zei!!!

Asa ca daca ne vom crea zeitattea .. adica IA … va fi pe masura noastra. Da nici noi nu ne placem prea mult!

D;aia as impusca preventiv pe toti aia care vor prea mult de la o IA ….

Ada.. daca avetim impresia ca eu imi cer scuze ca dpv cultural sunt arian .. si deci sămânța Dracului va inselati!!! E o identitate pe care mi-o asum!!

–––––––––––––––––––––––––

sămânța Dracului ..totusi trebe sa recunosc ca Timur Lenk ….

Au si tovarasii clone si roboti. Se pare ca robotii vor fi incercati pe tancurile occidentale. Este bine ca, colaboratorii sa se informeze din mai multe surse si apoi sa emita judecati.

vorbind de drac: https://www.defenseromania.ro/moment-istoric-in-industria-aeronautica-un-soft-cu-inteligenta-artificiala-a-pilotat-tip-de-17-ore-un-avion-de-vanatoare-f-16_621158.html

Tocmai citisem si eu stirea. Bineinteles ca in program sunt implicati si cei de la Skunk Works, cunoscatorii stiu!

https://www.thedrive.com/the-war-zone/m1-abrams-tank-tested-with-artificial-intelligence-targeting-system

https://ziare.com/avion-f16/superavion-american-cosmar-putin-avion-f16-condus-inteligenta-artificiala-premiera-mondiala-video-1789538